En 1942 Isaac Asimov escribe en uno de sus relatos de ficción científica 3 leyes que se deben integrar en lo más profundo del “cerebro” de los robots, su “código moral“. ¿Cómo pueden influir las tres leyes de Asimov en el coche autónomo?… ésta parece ser la gran pregunta para la plena implantación de los automóviles sin conductor.

Las tres leyes de la robótica escritas por Isaac Asimov pretenden evitar el temor natural del ser humano a una posible rebelión de las máquinas contra sus creadores, algo que el autor definió como “Complejo de Frankenstein“. Estas tres sencillas normas forman un bucle que evitaría esa posible rebelión:

- Un robot no podrá hacer daño a un ser humano o, por inacción, permitir que un ser humano sufra daño.

- Un robot debe obedecer las órdenes de un ser humano, salvo que éstas entren en conflicto con la primera ley.

- Un robot debe proteger su propia existencia en la medida en que esta protección no entre en conflicto con la primera y segunda ley.

Cuál es la finalidad principal del coche autónomo

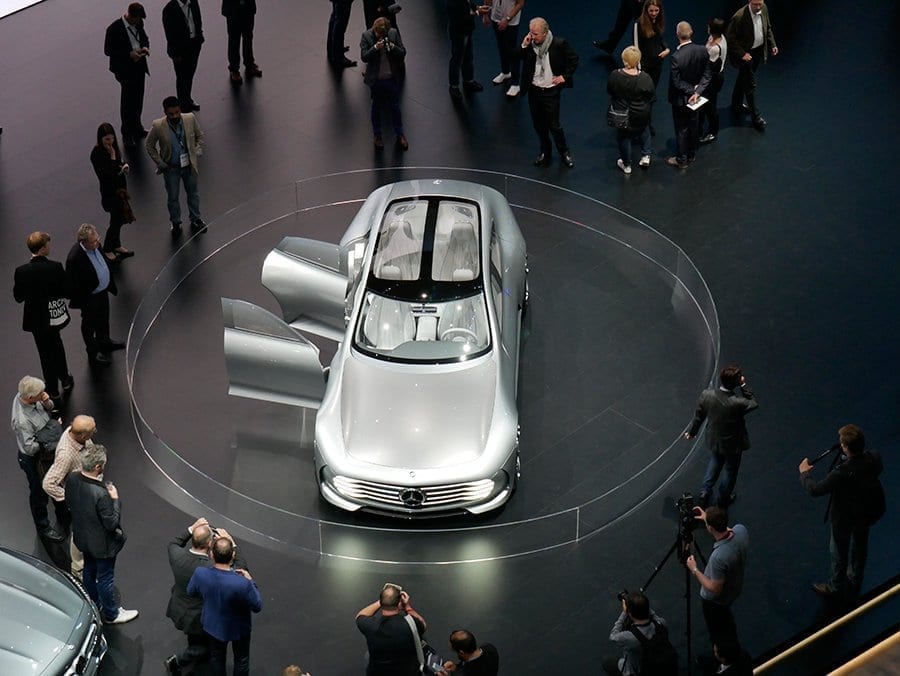

Todos los fabricantes de automóviles están apostando firmemente por la conducción autónoma. Desde hace años ya se está adaptando el diseño de los coches para que sean más interactivos entre sí. ¿Os habéis fijado en que ahora la parte trasera de los coches suele ser muy angulosa, con enormes salidas de escape de formas rectangulares, triangulares, defensas y nervaduras en la carrocería con muchas aristas…? El motivo es que de este modo resultan mucho “más visibles” para los sistemas de detección de obstáculos, controles de crucero adaptativos, alertas de colisión, etc.

En esta carrera por lograr lanzar al mercado el primer automóvil de conducción autónoma la mayoría de fabricantes apuntan a la misma fecha: 2020. En ese año, algunas compañías como Volvo afirman que su objetivo es que no muera nadie en un accidente de tráfico en sus vehículos.

Poco a poco los fabricantes nos están “reeducando” para que dejemos de ver el coche como algo en lo que disfrutar de la conducción. Cada vez nos abruman con más dispositivos que nos distraen (lo cual parece que va en contradicción con la situación actual, en la que el conductor debe concentrarse en conducir), conexión a internet, sistemas de infoentretenimiento cada vez más complejos, poder leer nuestro correo electrónico… de ese modo no echaremos de menos conducir cuando nos digan que no lo podremos hacer, porque, aunque no nos lo digan tan a las claras, una de las claves para que los coches puedan conducir de forma 100% autónoma es que no haya coches conducidos por humanos que puedan tener reacciones imprevistas. Sólo si el coche sabe de manera precisa lo que va a hacer el de al lado podrá conducir de forma autónoma con seguridad.

La tecnología ya permite en este momento que el coche pueda ser autónomo, pero hay dos problemas para que sean ya una realidad:

- Las infraestructuras deben adaptarse a la conducción autónoma. Para que los coches puedan conducir solos, deben poder recibir y enviar información a los semáforos, señales, conocer la situación del tráfico, si un tramo está cortado, si hay hielo en la calzada, etc. Para ello, las infraestructuras deberán adaptarse y mantenerse por parte de las autoridades.

- La legislación deberá adaptarse y permitir la conducción autónoma. En la actualidad, la ley prohíbe expresamente que el conductor se distraiga, así que, legalmente, un guardia civil nos podría sancionar si ahora mismo tuviésemos un coche que fuese capaz de conducir sin un conductor. Por otro lado, en caso de infracción, ¿quién es el culpable: vehículo o conductor?… Sí, ya sé que parece un diálogo de la película Airbag, pero es así.

Además de estos dos problemas, no son pocas las voces (como las de Jean-François Bonnefon, Azim Shariff, Iyad Rahwan) que ya están apuntando otro importante escoyo para el desarrollo y la implantación del coche autónomo: la ética y la moral. ¿Conducirías un coche que pudiese decidir matar a su conductor para salvar otras vidas? ¿Conducirías un coche que, para salvar a su conductor, pudiese acabar con la vida de otros?…

Por desgracia, el padre de las tres leyes de la robótica falleció el 6 de abril de 1992, una lástima que no haya podido asistir a este debate moral “hombre-máquina”.

En efecto, el coche autónomo nace bajo la premisa de reducir las muertes en accidentes de tráfico, definida por el filósofo Albert Camus como la muerte más idiota de todas (paradójicamente, él mismo falleció en uno pocas semanas después de tal afirmación). La realidad es que, aunque los fabricantes prometen que no morirá más gente en accidentes de tráfico gracias al coche autónomo, los siniestros son inevitables. El insumergible Titanic se hundió, los aviones con pilotos automáticos y mil protocolos de seguridad se estrellan, etc.

¿Cómo reaccionaría un coche autónomo si llega a una situación en la que el accidente fuese inevitable? La respuesta es simple: debería buscar el mínimo daño posible… y aquí empieza la controversia moral y su similitud con las tres leyes propuestas por el señor Asimov en 1942.

Coche autónomo: asesinar o suicidar

Hay varias situaciones que se plantean para poner diversos ejemplos que ponen en evidencia una paradoja ética a la hora de desarrollar el software que debe regir “la moral del coche autónomo“, pero todas se basan en lo mismo: ¿El coche autónomo debe decidir matar a otra persona para proteger la vida de sus ocupantes o sacrificar a sus ocupantes para salvar más vidas en una situación de accidente inevitable?.

Uno de los ejemplos propuestos es simple:

Un único pasajero circula en su coche autónomo y un grupo de personas está en medio de la trayectoria, sea por el motivo que sea. El vehículo no puede evitar el accidente y se le plantean dos alternativas: arrollar a ese grupo de personas para proteger la integridad de su pasajero o salirse de la carretera y sacrificar a su “conductor” para salvar las otras vidas. En un principio, aplicando la ley de los mínimos daños, debería “suicidar” a su ocupante para salvar más vidas y así minimizar las pérdidas humanas, pero… ¿comprarías o viajarías en un automóvil que sabes que te considera prescindible?. Si el fabricante decidiese dar prioridad a la vida de sus ocupantes, ¿comprarías o viajarías en un coche que pudiese tomar la decisión de asesinar a otras personas para salvar tu vida?… La disyuntiva asusta.

[ngg src=”galleries” ids=”30″ display=”basic_thumbnail”]

Diego Jambrina

Rubén Fidalgo

Diego Jambrina

Rubén Fidalgo